Les Transformers : Un voyage au coeur du Deep Learning !

Transformez votre entreprise grâce à la puissance et polyvalence des Transformers !

Les Transformers, de quoi parle-t-on ?

Le terme « Transformers » désigne un type particulier de modèles de deep learning. Les Transformers (ou modèles auto attentifs) sont une famille d’architectures de réseaux de neurones artificiels utilisées pour des tâches telles que :

- la traduction automatique,

- la génération de texte,

- la reconnaissance vocale,

- la compréhension du langage naturel,

- la classification de texte.

Par exemple, ils peuvent être utilisés pour analyser et comprendre le sentiment dans des commentaires liés à des produits ou services, traduire un document d’une langue à une autre, générer du texte dans un style spécifique, transcrire du discours en texte ou encore pour classifier automatiquement des tickets de maintenance en fonction de leur contenu… Ils se distinguent par leur capacité à capturer les relations entre les différentes parties d’un ensemble de données, ce qui les rend polyvalents et adaptés à une variété de problématiques.

Leur fonctionnement est simple

Les Transformers adoptent une architecture entièrement basée sur l’attention. Contrairement aux modèles traditionnels, ils se concentrent sur les différents éléments de la séquence d’entrée, sans suivre un ordre séquentiel strict. L’élément clé de cette approche est l’attention, qui permet au modèle de pondérer l’importance de chaque entrée lors de la génération de la sortie.

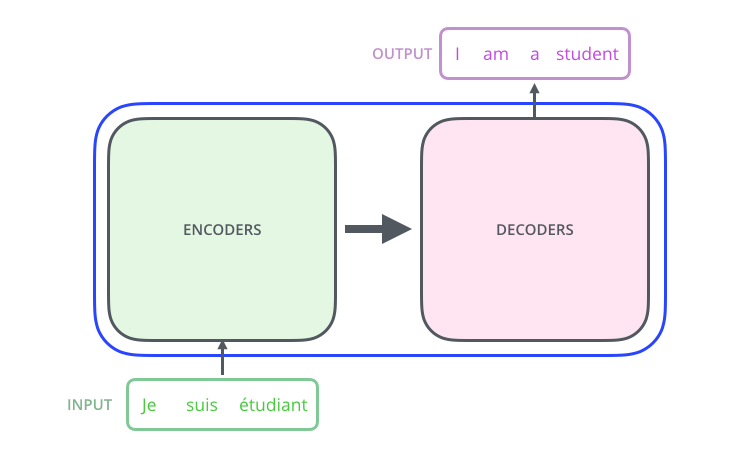

Un Transformer est composé de deux parties principales : l’encodeur et le décodeur.

L’encodeur prend une séquence en entrée et la transforme en une représentation continue, capturant ainsi les informations contextuelles essentielles. Le décodeur utilise cette représentation continue pour générer la séquence de sortie souhaitée.

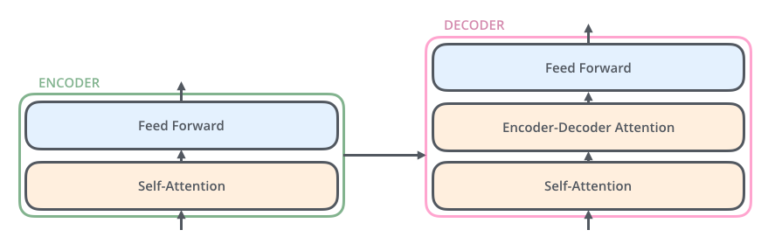

Chacune de ces parties est constituée de plusieurs couches identiques, qui intègrent des mécanismes d’attention multi-têtes, de la normalisation par couches et une connexion résiduelle.

Les mécanismes d’attention multi-têtes examinent simultanément différentes parties de la séquence pour capturer les dépendances à long terme. La normalisation par couches assure la stabilité du modèle, tandis que la connexion résiduelle facilite le flux d’informations entre les couches. Grâce à cette architecture puissante, les Transformers captent les informations globales et gèrent efficacement les dépendances à long terme.

Les avantages

Les Transformers représentent une avancée significative dans le domaine de l’apprentissage automatique. Leur architecture basée sur l’attention offre des avantages majeurs par rapport aux modèles traditionnels tels que les réseaux de neurones récurrents (RNN) et les réseaux convolutifs (CNN).

Tout d’abord, ils sont parallélisables, ce qui signifie qu’ils peuvent traiter simultanément toutes les positions de la séquence. Contrairement aux RNN qui nécessitent un traitement séquentiel, cette capacité améliore l’efficacité du calcul, permettant une analyse rapide des données.

De plus, les Transformers peuvent gérer les longues dépendances temporelles de manière efficace grâce à leur architecture. Cela permet aux Transformers de modéliser de manière précise les interactions entre les parties d’une séquence et d’appréhender les dépendances à long terme.

En outre, leur flexibilité est un atout majeur. Ils peuvent être adaptés à une variété de tâches, allant de la traduction automatique à la génération de texte en passant par la classification. Leur architecture modulaire, composée d’un encodeur et d’un décodeur, permet de les ajuster pour répondre aux spécificités de chaque tâche.

En résumé, les Transformers offrent des avantages clés : parallélisabilité, gestion efficace des dépendances à long terme et flexibilité pour diverses tâches. Leur capacité à capturer les relations complexes et à apprendre des représentations précises en fait une approche puissante et prometteuse.

Cas d’utilisation des Transformers

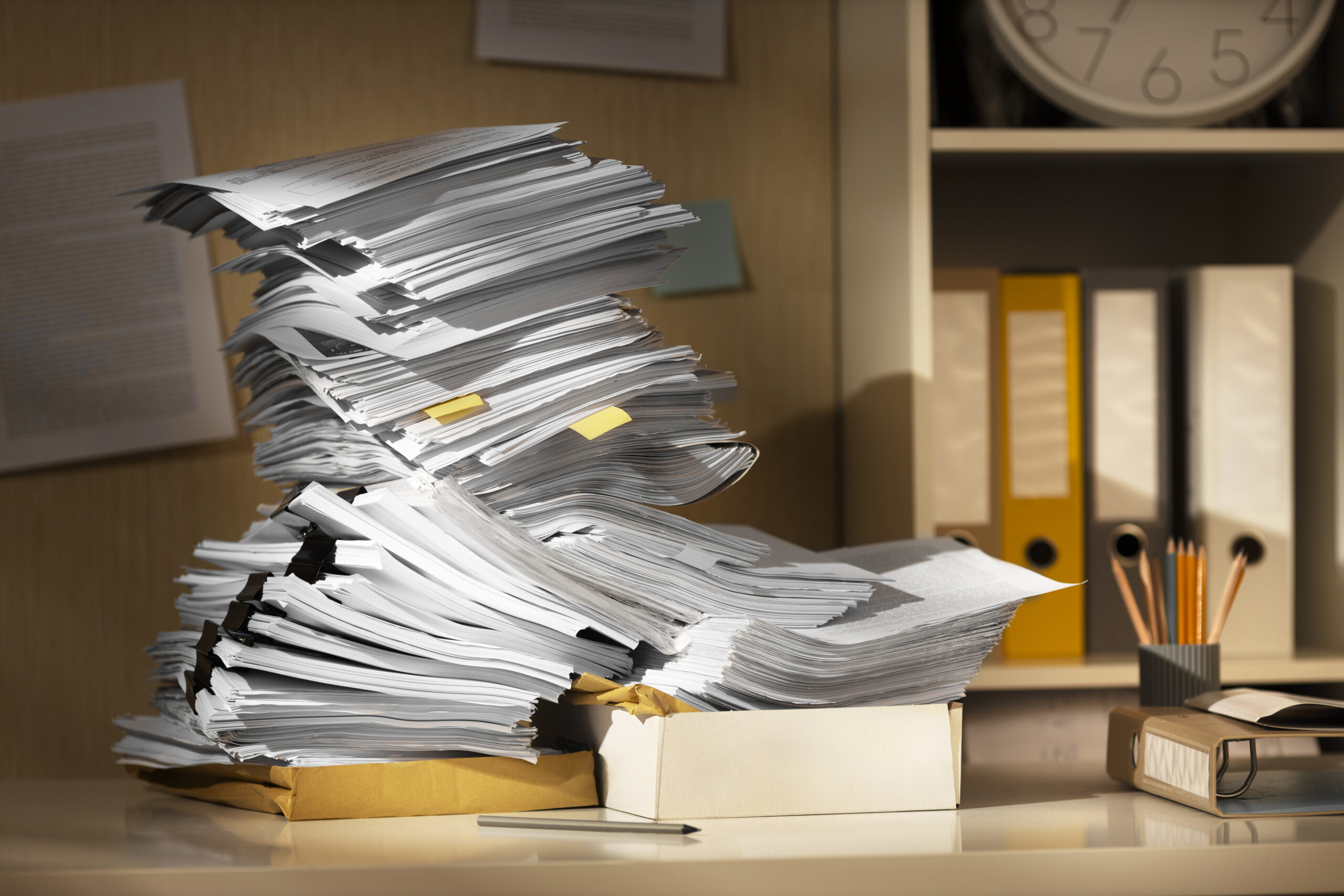

Un exemple d’utilisation des Transformers peut être trouvé dans la classification automatique des tickets de maintenance.

Dans ce scénario, certaines entreprises reçoivent quotidiennement des centaines, voire milliers de tickets de maintenance de la part de leurs clients ou utilisateurs. Ces tickets peuvent couvrir une grande variété de problèmes, et il peut être fastidieux et coûteux de les trier manuellement.

En utilisant un Transformer, il est possible d’entraîner un modèle à lire et à comprendre le contenu de chaque ticket, puis à le classer dans la catégorie appropriée.

Par exemple, si un client/utilisateur se plaint d’un point bloquant lié à sa connexion Internet, le modèle pourrait automatiquement classer ce ticket dans la catégorie « Problèmes de réseau ». Cela permet de gagner du temps et des ressources, mais aussi d’assurer une réponse plus rapide et plus efficace aux problèmes.

Cette classification automatique des tickets de maintenance présente de nombreux avantages :

- Efficacité : Automatisation du tri des tickets, réduisant le temps administratif.

- Réponse plus rapide : Acheminement rapide des tickets au bon département.

- Précision : Compréhension nuancée du langage pour une classification précise.

- Évolutivité : Gestion facile de volumes importants de tickets sans impact sur les performances.

- Apprentissage continu : Amélioration constante de la précision avec l’apprentissage adaptatif.

- Analyse des tendances : Identification de modèles pour l’amélioration du produit et du service utilisateur.

En conclusion, les Transformers ont apporté une révolution dans le domaine du deep learning grâce à leur architecture novatrice basée sur l’attention. Leur capacité à traiter efficacement diverses tâches et à s’adapter ouvre des perspectives prometteuses. Alors que le domaine continue d’évoluer, de nouvelles possibilités d’utilisation et d’amélioration des Transformers se profilent à l’horizon.

Le blog

-

Adoption de l’IA : et si les RH prenaient (vraiment) le lead ?

-

Exploiter la puissance des RAG pour analyser des volumes massifs de données et transformer votre activité

-

Databricks, Synapse ou Fabric : quelle solution pour votre stratégie data ?

-

Implémenter un RAG efficace : les bonnes pratiques essentielles