Pourquoi l’IA générative va changer la manière dont on aborde la qualité de données ?

Le non-déterministe à grande échelle

L’IA générative introduit un changement fondamental dans nos systèmes : le non déterministe. Contrairement aux systèmes classiques, une IA générative ne garantit pas qu’une même requête produira toujours le même résultat. À partir d’un même prompt, elle génère une réponse… probable, pas certaine.

Ce non-déterminisme n’est pas nouveau en soi.

Mais l’IA générative l’introduit à une échelle jamais atteinte : dans les outils du quotidien, dans les processus métiers, dans des usages auparavant très structurés.

C’est précisément pour cette raison que la manière dont on aborde la qualité de la donnée est obligée de changer. Les cadres hérités de systèmes déterministes ne suffisent plus.

C’est quoi la qualité de la donnée aujourd’hui ?

Historiquement, la qualité de la donnée s’est construite autour d’un objectif clair : reprendre le contrôle.

Contrôle de l’exactitude, de la complétude, de la cohérence, de la fraîcheur.

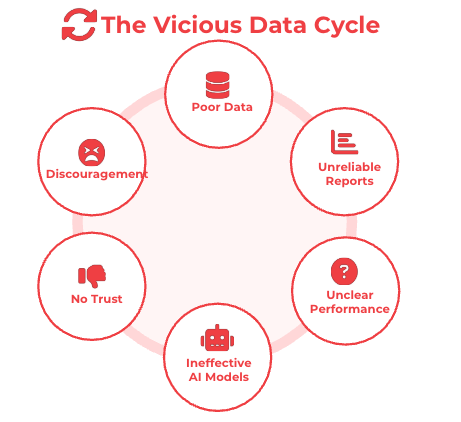

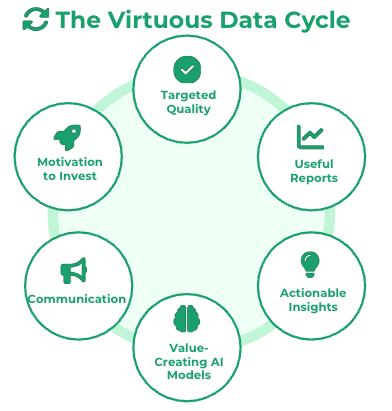

Cette approche répond à une réalité bien connue : les cercles vicieux de la donnée.

L’enjeu de la qualité est alors de casser ce cercle pour rétablir un cercle vertueux :

Deux grandes stratégies coexistent :

Une stratégie défensive, très présente en France, qui vise à sécuriser, gouverner et contrôler avant tout usage.

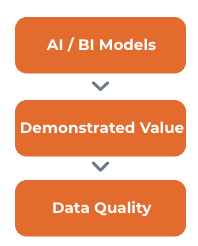

Une stratégie offensive, plus pragmatique, qui consiste à créer de la valeur même avec des données imparfaites, puis à améliorer la qualité là où l’impact est réel.

Mais ces deux stratégies partagent une même hypothèse implicite : si la donnée est de qualité, alors le résultat sera de qualité. Une hypothèse valable… dans un monde déterministe.

Le constat avec l’IA générative : la fin du déterminisme

Avec l’IA générative, cette équation ne tient plus.

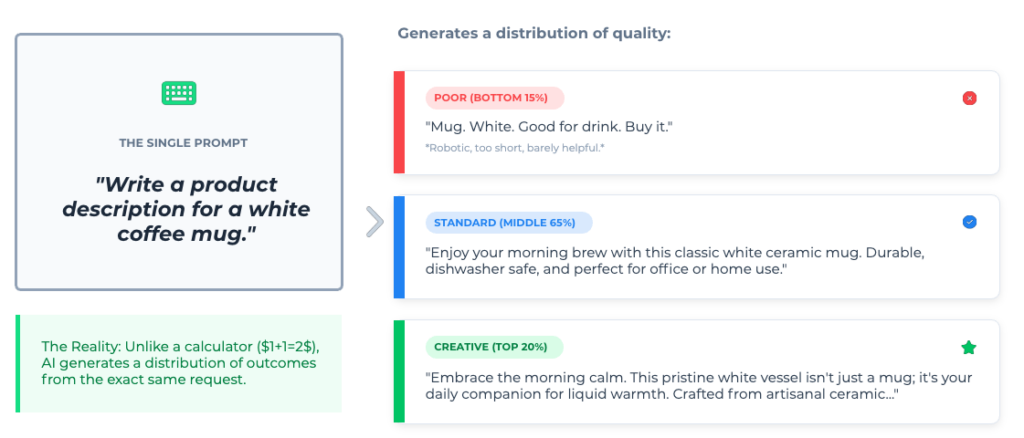

Prenons une requête simple :

La donnée n’a pas changé. Le prompt n’a pas changé. Mais le résultat, lui, varie. Ce comportement n’est pas un bug : c’est le fonctionnement normal d’un système probabiliste.

Exactement comme un humain.

Quand un manager confie une tâche à son équipe, il sait intuitivement qu’il va obtenir :

- quelques rendus médiocres,

- une majorité de rendus “dans la moyenne”,

- parfois des résultats remarquables.

Et surtout, il ne confond jamais output et outcome. Un mauvais output n’est pas exposé, il est repris, corrigé, ou écarté.

Avec l’IA générative, la qualité ne peut donc plus être pensée comme un ensemble de règles figées à respecter en amont. On ne peut plus “mettre l’IA dans des cases” comme on le faisait avec des systèmes déterministes.

Cela impose un changement de posture : remettre l’humain dans la boucle. Non pas pour tout contrôler, mais pour évaluer les sorties, filtrer les mauvais outputs, transformer le feedback humain en signal de qualité.

C’est ce que recouvrent des approches émergentes comme le Human-in-the-Loop ou le Probabilistic Ops. La qualité n’est plus garantie par le contrôle strict de la donnée, mais par la capacité du système à apprendre, s’ajuster et s’améliorer dans le temps.

Pourquoi l’IA générative change notre rapport à la qualité de la donnée

L’IA générative ne remet pas en cause l’importance de la qualité de la donnée. Elle remet en cause la manière dont on la conçoit.

Dans un monde non-déterministe, la qualité ne peut plus être uniquement garantie par des règles ou des contrôles en amont. Elle repose sur la capacité des organisations à outiller, responsabiliser et faire monter en compétence leurs collaborateurs.

Experts métiers, équipes data, IT, managers : ce sont eux qui deviennent les véritables garants de la qualité des usages. En évaluant les outputs, en corrigeant les dérives, en apportant du feedback, ils transforment l’IA générative en un système qui apprend, s’améliore et crée de la valeur dans la durée.

C’est là que se joue le vrai enjeu, non pas chercher une donnée parfaite partout, mais donner aux équipes les moyens de piloter la qualité là où elle a un impact réel, et d’éviter qu’un mauvais output ne devienne un mauvais outcome.

Chez Valoway, nous accompagnons les organisations dans le cadrage, l’industrialisation et la gouvernance de ces usages, avec une conviction forte :

dans un monde probabiliste, la qualité n’est plus une conformité à atteindre, mais une responsabilité collective à piloter.

Le blog

-

Chat with your data : le vieux fantasme de l’analytics qui devient enfin une vraie option

-

Pourquoi l’IA générative va changer la manière dont on aborde la qualité de données ?

-

Développer à l’ère de l’IA : quand coder n’est plus l’essentiel du métier

-

L’IA dans Fabric : Comment Microsoft Fabric met l’IA au service des équipes Data et IT